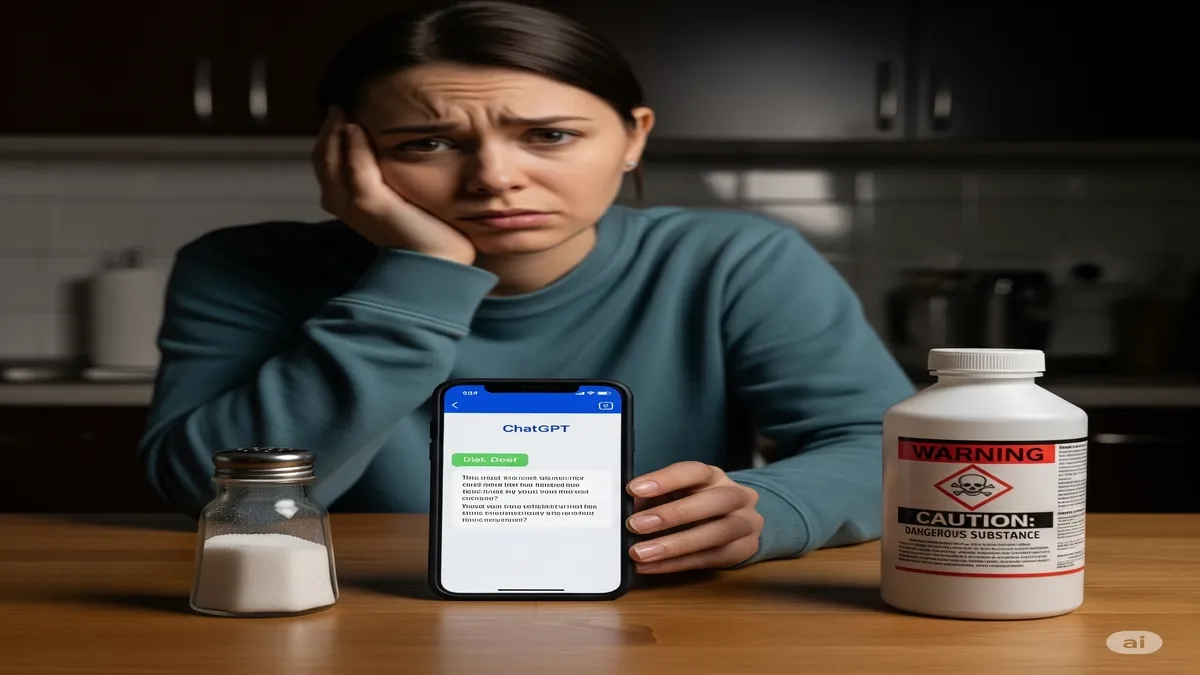

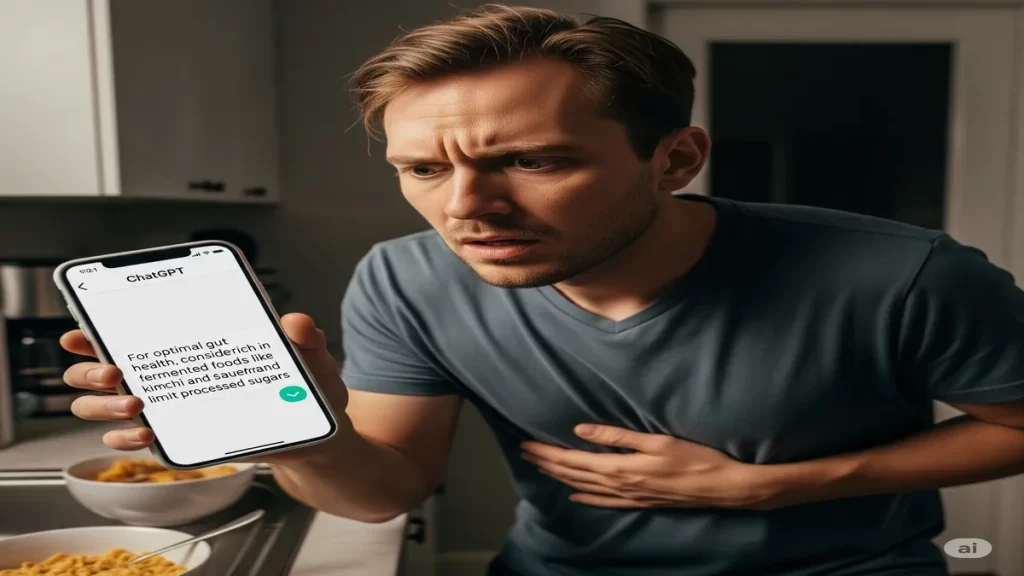

ChatGPT की सलाह मानकर हुआ खतरनाक हाल: शख्स पहुंचा अस्पताल

Man falls sick from ChatGPT advice: Know the reason: ऑनलाइन डाइट प्लान पड़ा महंगा: ChatGPT की सलाह पर चला शख्स, हो गई ब्रोमाइड की अधिकता

आज के समय में ChatGPT एक बहुत लोकप्रिय, AI टूल बन गया है। लोग इसका इस्तेमाल, कई कामों के लिए करते हैं। लेकिन ChatGPT से स्वास्थ्य से जुड़ी, सलाह लेना खतरनाक हो सकता है। एक 60 वर्षीय व्यक्ति, न्यूयॉर्क में रहने वाला, इसका ताजा उदाहरण है। उन्होंने अपनी त्वचा की समस्या, के लिए चैटजीपीटी से सलाह ली थी। उस सलाह के बाद वे गंभीर रूप से बीमार, होकर अस्पताल पहुंच गए।

यह ChatGPT के गलत इस्तेमाल का, एक बड़ा उदाहरण है।

ChatGPT ने दी थी यह खतरनाक सलाह

दरअसल, उस शख्स ने अपनी डाइट में, से नमक (सोडियम क्लोराइड) हटाना चाहा। इसके लिए उन्होंने चैटजीपीटी से, कोई विकल्प सुझाने को कहा। AI ने उन्हें सोडियम ब्रोमाइड, का इस्तेमाल करने की सलाह दी। चैटजीपीटी की सलाह पर भरोसा करके, उस शख्स ने तीन महीने तक, सोडियम ब्रोमाइड का, उपयोग किया। यह उनके लिए बहुत ही, खतरनाक साबित हुआ।

यह ChatGPT से मिली, एक गलत जानकारी थी।

क्या हुआ जब शख्स ने सलाह मानी?

सोडियम ब्रोमाइड का सेवन करने से, उस व्यक्ति को ब्रोमाइड विषाक्तता हो गई। इस स्थिति को ब्रोमिज्म भी, कहा जाता है। वह व्यक्ति मतिभ्रम, बेचैनी और, शारीरिक तालमेल की कमी, जैसे लक्षणों से पीड़ित था। उसे लगा कि उसका पड़ोसी, उसे जहर दे रहा है। उसके शरीर पर लाल रंग के, दाने भी निकल आए थे। डॉक्टरों को उसकी हालत, देखकर उसे अस्पताल में भर्ती, करना पड़ा।

यह ChatGPT की सलाह का, गंभीर परिणाम था।

क्यों नहीं लेनी चाहिए चैटजीपीटी से स्वास्थ्य सलाह?

- यह घटना हमें सिखाती है कि, AI चिकित्सा सलाह, देने के लिए नहीं है।

- चैटजीपीटी एक डेटा-संचालित मॉडल है, जो जानकारी को, सही ढंग से नहीं समझ पाता।

- यह इंसानी डॉक्टर की तरह, आपके लक्षणों और, मेडिकल हिस्ट्री को नहीं, समझ सकता है।

- इसलिए स्वास्थ्य से जुड़ी, किसी भी सलाह के लिए, हमेशा डॉक्टर से संपर्क करें।

यह चैटजीपीटी के उपयोग को लेकर, एक महत्वपूर्ण चेतावनी है।

ChatGPT health advice, AI diet plan, Bromide poisoning, Medical advice, AI dangers

Sea Mystery: 5 अरब समुद्री सितारों को खत्म करने वाले बैक्टीरिया को जानें